LM Studio是一个允许您的工具运行本地大型语言模型(LLM)在您的计算机上。关于此实用程序的最好的事情之一是,它允许您在本地运行模型以确保最大的隐私。在本指南中,我们将配置LM Studio在离线PC上使用多个AI,因此,如果您有兴趣,请继续阅读。

配置LM Studio在离线PC上使用多个AI

LM Studio允许您在计算机上下载和运行大型语言模型,而无需互联网。它通过在本地处理所有内容来帮助您保持数据私密。有了它,您可以将多个AI模型用于内容创建和数据分析等任务。如果要配置LM Studio在离线PC上使用多个AI,请按照下面的步骤进行操作。

- 安装LM Studio

- 安装多个型号

- 开始使用模型

让我们详细讨论它们。

1]安装LM工作室

首先,我们需要从其官方网站获取LM Studio工具。因此,您需要去lmstudio.ai。由于我正在使用Windows,我会选择下载用于Windows的LM Studio,但是根据您的平台,您需要下载LM Studio版本。完成后,这将触发尊敬的EXE文件的下载。

下载LM Studio安装媒体后,请双击它,然后选择要安装应用程序的用户。如果要为所有用户安装它,则需要访问管理员,因为它将获得UAC提示。由于我有访问权限,因此我这样做了,然后选择了该文件夹,最后启动了该应用程序。

2]安装多个型号

启动LM Studio后,将提示您下载第一个LLM型号,请单击获得第一个LLM,然后下载建议的模型。如果您要选择自己的型号,请单击跳过登机。

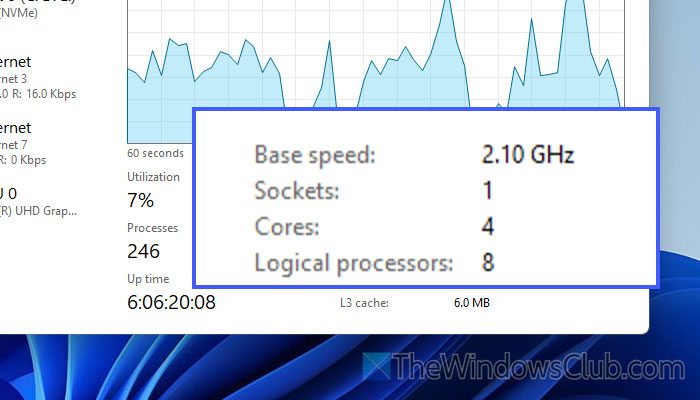

要下载任何LLM型号,您需要单击发现(放大镜)图标。现在,搜索要下载的模型。 LM Studio最好的事情之一是它检查您的系统详细信息,并告诉您该机器是否太大。例如,DeepSeek编码器V2 Lite对于我的设备来说太大了,而致电3.2 1B会顺利运行。

一旦知道哪种型号将在机器上工作,请单击下载图标,让它下载模型。根据您的网络带宽,可能需要一些时间。

这将下载LLM模型以及运行时。但是,如果您想升级到其他型号,就我而言,我想安装cpu llama.cpp,因为我没有强大的GPU和GPU-ACCELERATY,而GPU-Acceleration并不是我的机器可以处理的东西,我去了运行时标签,然后单击更新按钮旁边是运行时模型。

为了下载另一个模型,你需要去发现再次按钮,查找要下载的模型。然后,单击下载与之关联的按钮。等待几分钟下载您的模型。下载后,您可以转到运行时下载任何更新(如果有),如果需要,然后您要做的就是单击负载模型。这将在您的计算机上本地启动该模型的服务器。

注意:如果您在不启动模型的情况下关闭了发现提示,请转到屏幕左下角的下载图标,然后选择与模型关联的负载模型。

3]开始使用模型

下载模型后,您需要做的就是转到聊天图标。然后,查看窗口的顶部,您将看到所有模型,请单击模型您想选择的。

您甚至可以在使用模型之前更改模型的偏好。为此,单击模型旁边的侧箭头,然后更改设置,例如GPU卸载,CPU线程池大小,上下文长度,和其他选项。完成后,只需单击负载模型。

加载模型后,转到聊天机器人并开始与AI模型聊天。确保注意窗口右下角的RAM和CPU计数。

希望在本指南的帮助下,您将能够在LM Studio中运行多个LLM型号。但是,还有其他您也应该检查它们。

读:

LM Studio脱机工作吗?

是的,LM Studio离线工作。下载了必要的型号和运行时,您可以完全不使用Internet连接。所有处理均在您的计算机上本地进行,以确保您的数据保持私密。

读:

LM Studio需要多少RAM?

LM Studio中的每个型号都有不同的RAM要求。但是,如果您想在没有问题的情况下运行任何模型,我们建议您至少有16 GB的RAM。此外,如果您有能力添加GPU,请执行此操作。

另请阅读:。