您希望您的数据保持私密并且永远不会离开您的设备吗? Cloud LLM 服务通常会根据 API 调用收取持续订阅费。即使是偏远地区或互联网连接不可靠的用户也不会特别喜欢云服务。那么解决办法是什么呢?

幸运的是,本地法学硕士工具可以消除这些成本,并允许用户在其硬件上运行模型。这些工具还可以离线处理数据,以便外部服务器无法访问您的信息。您还可以更好地控制特定于您的工作流程的界面。

在本指南中,我们收集了免费本地法学硕士工具满足您的所有条件,同时满足您的隐私、成本和性能需求。

在 Windows 11 PC 上本地运行 LLM 的免费工具

这里有一些经过精心挑选和亲自测试的免费本地法学硕士工具。

- 扬

- LM工作室

- GPT4ALL

- 任何法学硕士

- 成为

1]一月

您熟悉 ChatGPT 吗?如果是这样,Jan 就是一个可以离线工作的版本。您可以在没有互联网的情况下在您的个人设备上运行它。它允许您在本地网络上私下生成、分析和处理文本数据。

它配备了 Mistral、Nvidia 或 OpenAI 等一流模型,您无需将数据发送到另一台服务器即可使用。如果您优先考虑此工具,则适合并希望有一个强大的替代方案来替代基于云的法学硕士。

特征

- 预建模型:它提供已安装的 AI 模型,无需额外程序即可使用。

- 定制:更改仪表板的颜色并使主题变为纯色或半透明。

- 拼写检查:使用此选项可以修复拼写错误。

优点

- 使用 Hugging Face 源导入模型。

- 它支持定制扩展。

- 免费

缺点

- 社区支持较少 Jan 缺乏社区支持,用户可能会发现较少的教程和资源。

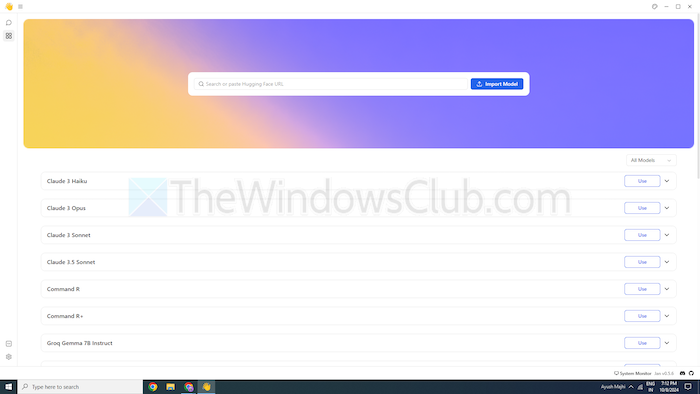

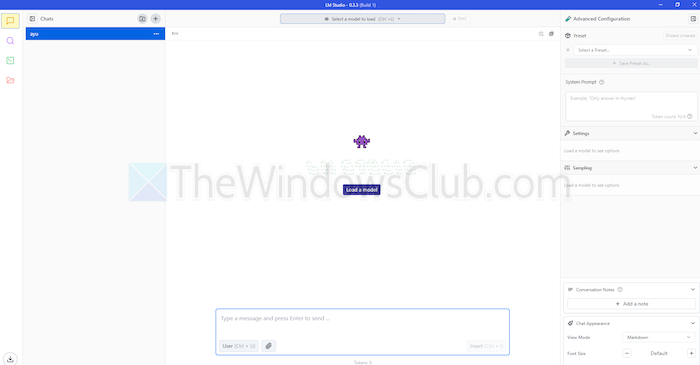

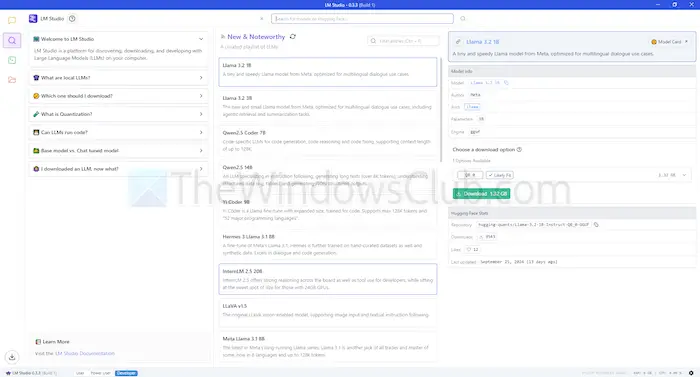

2]LM工作室

LM Studio 是另一个在本地使用语言模型的工具,例如 ChatGPT。它提供大型、增强的模型来理解和响应您的请求。但是,与基于云的模型不同,您可以留在设备上。换句话说,对其使用有更多的隐私和控制。

LM Studio 可以在您的机器上总结文本、生成内容、回答您想要的问题,甚至协助编码。在运行模型之前,您可以获得有关您的系统是否可以处理该模型的报告。这样您就可以只将时间和资源花在兼容的型号上。

特征

- 文件附件和 RAG:您可以在聊天框下上传 PDF、docx、txt 和 CSV 文件并获得相应的回复。

- 定制范围:它提供多种颜色主题,并允许您选择界面的复杂程度。

- 资源密集:它提供免费文档以及学习和使用该工具的方法。

优点

- 您可以在 Linux、Mac 或 Windows 上使用它。

- 为开发人员设置本地服务器。

- 它提供了精选的模特播放列表

缺点

- 开始工作可能很复杂,特别是对于新人来说。

3]GPT4ALL

GPT4ALL 是另一个 LLM 工具,无需互联网连接甚至 API 集成即可在您的设备上运行模型。该程序在没有 GPU 的情况下运行,但它可以利用 GPU(如果可用),这使其适合许多用户。它还支持一系列 LLM 架构,这使得它与开源模型和框架兼容。

它还使用 llama.cpp 作为 LLM 的后端,这可以在没有高端基础设施的情况下提高 CPU 和 GPU 上的模型性能。 GPT4ALL 兼容 Intel 和 AMD 处理器;它使用 GPU 来实现更快的处理。

特征

- 本地文件交互:模型可以查询本地文件并与本地文件交互。与 PDF 或文本文档一样,使用本地文档。

- 高效的:许多模型都有 4 位版本,该版本使用更少的内存和处理能力。

- 广泛的模型库:GPT4ALL 拥有来自 Hugging Face 等存储库的 1000 多个开源模型。

优点

- 开源透明

- 它为企业在本地使用人工智能提供了特定的套餐。

- GPT4ALL 强烈关注隐私

缺点

- 对 Chromebook 等 ARM 处理器的有限支持

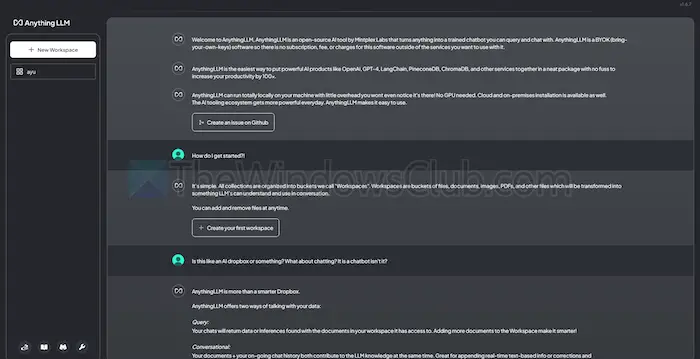

4]任何事情法学硕士

AnythingLLM 是一个开源法学硕士,提供高度定制和私人人工智能体验。它允许用户在本地设备(例如 Mac、Windows 或 Linux)上离线部署和运行 LLM,从而确保完整的

此外,该工具最适合希望以最少的设置获得易于安装的解决方案的单个用户。您可以将其视为企业或个人都可以运行的类似于 CharGPT 的私有系统。

特征

- 开发者友好:它具有用于自定义集成的完整 API。

- 工具集成:您可以集成其他工具并生成 API 密钥。

- 轻松设置:它有一个单击安装过程。

优点

- LLM 使用的灵活性

- 以文档为中心

- 该平台有人工智能代理来自动执行任务

缺点

- 缺乏多用户支持

- 高级功能的复杂性

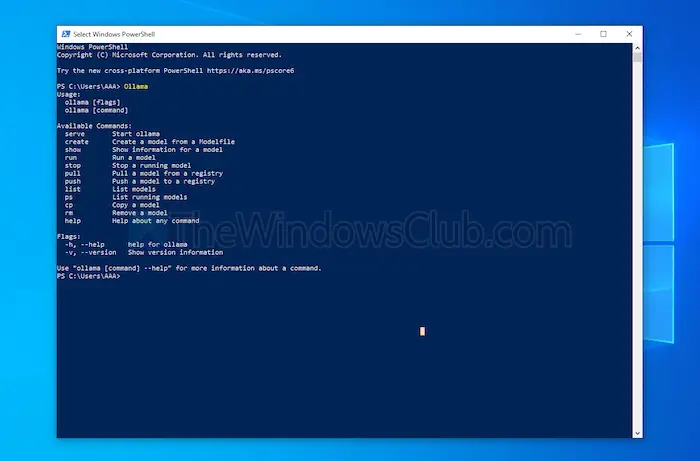

5] 成为

Ollama 无需 API 即可完全控制创建本地聊天机器人。目前,它拥有最重要的贡献者,他们提供频繁的更新并改进 GitHub 的整体功能。这更新了该工具并提供了比其他工具更好的性能。与上面讨论的其他工具不同,它打开一个终端界面来安装和启动模型。

您安装的每个型号都有自己的配置和权重,避免与计算机上的其他软件发生冲突。除了命令行界面之外,Ollama 还具有与 OpenAI 兼容的 API。您可以轻松地将此工具与使用 OpenAI 模型的工具集成。

特征

- 本地部署:Ollama 允许您离线运行大型语言模型,例如 Llama、Mistral 或其他。

- 型号定制:高级用户可以使用模式文件设置模型中的行为。

- OpenAI API 兼容性:它有一个与 OpenAI 的 API 兼容的 REST API。

- 资源管理:它优化了 CPU 和 GPU 的使用,而不会使系统超载。

优点

- 您可以获得模型的集合。

- 它可以从 PyTorch 等开源库导入模型。

- Ollama 可以集成强大的图书馆支持

缺点

- 它不提供图形用户界面

- 需要大量存储需求

结论

总之,本地法学硕士工具为基于云的模型提供了一个有价值的替代方案。它们免费提供更高级别的隐私和控制。无论您的目标是易于使用还是定制,列出的工具都可以满足各种需求和专业水平。

根据您的需求,例如处理能力和兼容性,其中任何一个都可以利用人工智能的潜力,而不会损害隐私或需要订阅费。

![Razer Synapse正在最小化游戏[FIX]](https://sclub.homes/tech/blogs/wp-content/uploads/2025/02/Razer-Synapse-is-minimizing-games.png)