Llama 3 是 Meta 最新的大型语言模型。您可以将其用于各种目的,例如解决您的疑问、获得学校作业和项目的帮助等。在本地 Windows 11 计算机上部署 Llama 3 将帮助您随时使用它,即使无法访问互联网。这篇文章向您展示如何在 Windows 11 PC 上安装 Llama 3。

如何在 Windows 11 PC 上安装 Llama 3

通过 Python 在 Windows 11 PC 上安装 Llama 3 需要技术技能和知识。但是,一些替代方法允许您在 Windows 11 计算机上本地部署 Llama 3。我将向您展示这些方法。

要在 Windows 11 PC 上安装 Llama 3,您必须在命令提示符中执行一些命令。但是,这仅允许您使用其命令行版本。如果您想使用其 Web UI,则必须采取进一步的步骤。我将向您展示这两种方法。

通过 CMD 在 Windows 11 PC 上部署 Llama 3

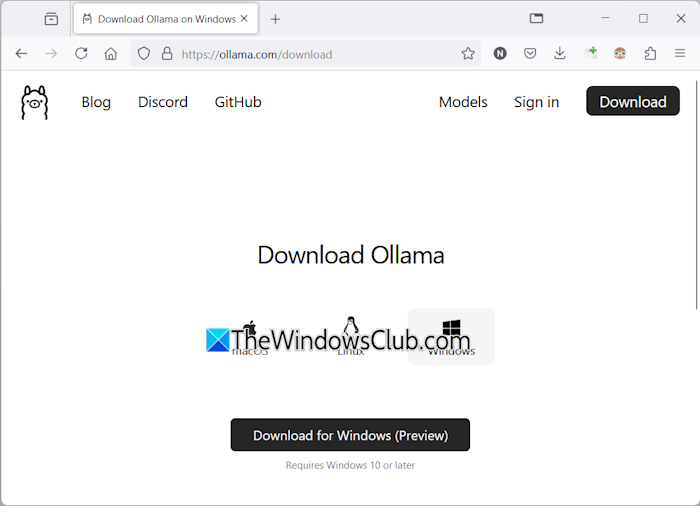

要在 Windows 11 PC 上部署 Llama 3,您需要在 Windows 计算机上安装 Ollama。其步骤如下:

- 访问奥拉玛官方网站。

- 单击下载按钮,然后选择视窗。

- 现在,单击下载 Windows 版按钮将 exe 文件保存到您的 PC 上。

- 运行 exe 文件以在您的计算机上安装 Ollama。

在您的设备上安装 Ollama 后,重新启动计算机。它应该在后台运行。您可以在系统托盘中看到它。现在,单击 Ollama 网站上的“模型”选项。您会看到它的不同型号。

Llama 3.1有以下三个参数:

- 8B

- 70B

- 405B

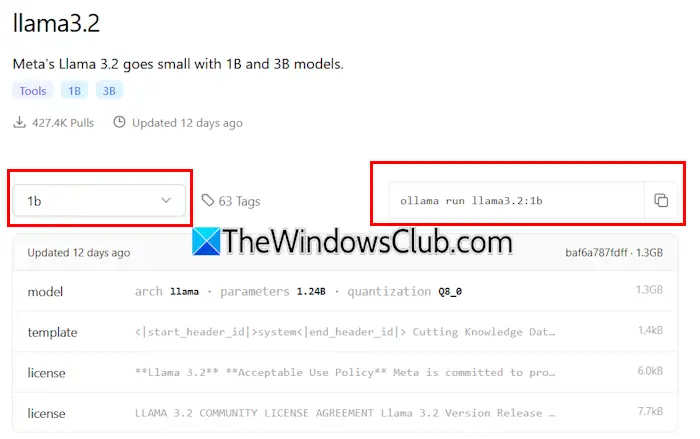

最后一项是最大的参数,显然无法在低端PC上运行。 Llama 3.2有以下两个参数:

- 1B

- 3B

单击您要在 PC 上安装的 Llama 版本。例如,如果您要安装 Llama 3.2,请单击 Llama 3.2。在下拉列表中,您可以选择要安装的参数。之后,复制旁边的命令并将其粘贴到命令提示符中。

为了您的方便,我为 Llama 3.2 模型编写了这两个命令。要安装 Llama 3.2 3B 模型,请运行以下命令:

ollama run llama3.2:3b

要安装 Llama 3.2 1B 模型,请使用以下命令:

ollama run llama3.2:1b

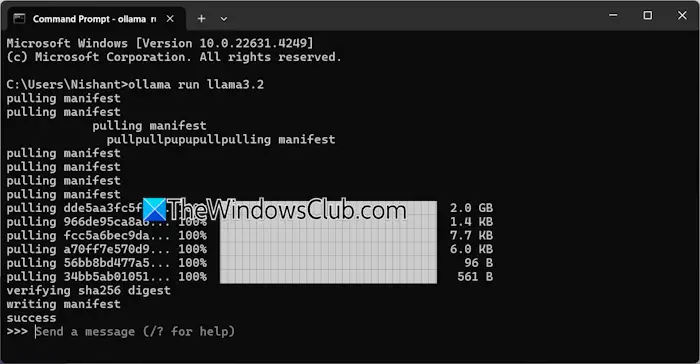

打开命令提示符,键入上述任何命令(根据您的要求),然后点击进入。下载所需的文件需要一些时间。下载时间还取决于您的互联网连接速度。完成后你会看到成功命令提示符中的消息。

现在,输入消息以使用 Llama 3.2 模型。如果您想安装 Llama 3.1 模型,请使用 Ollama 网站上提供的命令。

下次启动命令提示符时,请使用相同的命令在 PC 上运行 Llama 3.1 或 3.2。

通过 CMD 安装 Llama 3 有一个缺点。它不会保存您的聊天记录。但是,如果您将其部署在本地主机上,您的聊天记录将被保存,并且您将获得更好的用户界面。下一个方法展示了如何做到这一点。

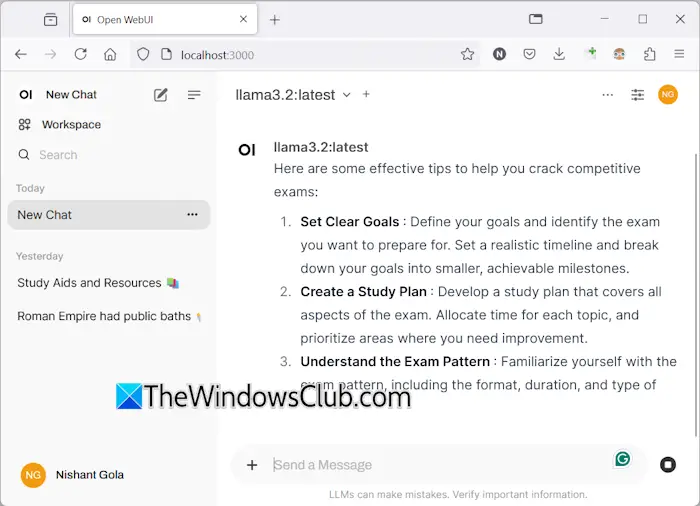

在 Windows 11 上部署 Llama 3 Web UI

与在 CMD 窗口上使用相比,在 Web 浏览器上使用 Llama 3 可以提供更好的用户界面,并且还可以保存聊天历史记录。我将向您展示如何在 Web 浏览器上部署 Llama 3。

要在 Web 浏览器中使用 Llama 3,应通过 Ollama 和 Docker 在您的系统上安装 Llama 3。如果您尚未安装 Llama 3,请使用 Ollama 安装它(如上所述)。现在,从其下载并安装 Docker官方网站。

安装 Docker 后,启动它并注册创建一个帐户。在您注册之前,Docker 不会运行。注册后,在 Docker 应用程序上登录您的帐户。将 Docker 最小化到系统托盘。 Docker 和 Ollama 应用程序应在后台运行。否则,您将无法在网络浏览器中使用 Llama 3。

现在,打开命令提示符,复制以下命令,并将其粘贴到命令提示符中:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

上述命令将需要一些时间来下载所需的资源。因此,要有一些耐心。命令完成后,打开Docker并选择集装箱从左侧开始的部分。您将看到自动创建了一个容器,端口为 3000:8080。

单击端口 3000:8080。这将在您的默认网络浏览器中打开一个新选项卡。现在,注册并登录以在网络浏览器上使用 Llama 3。如果您看到地址栏,您将看到本地主机:3000那里,这意味着 Llama 3 托管在您的计算机本地。您可以在没有互联网连接的情况下使用它。

从下拉列表中选择您的 Llama 聊天模型。如果您想添加更多 Llama 3 的聊天模型,您必须使用所需的命令通过 Ollama 安装它。之后,该模型将自动在您的网络浏览器中可用。

您的所有聊天记录都将保存并可在左侧访问。当您想退出时,请在网络浏览器中注销您的会话。之后,打开 Docker 应用程序并单击停止按钮来停止 Docker。现在,您可以关闭 Docker。

当您下次想在 Web 浏览器中使用 Llama 3 时,启动 Ollama 和 Docker,等待几分钟,然后单击 Docker 容器中的端口以在 Web 浏览器中打开 localhost 服务器。现在,登录您的帐户并开始使用 Llama 3。

我希望这有帮助。

Llama 3 可以在 Windows 上运行吗?

根据您计算机的硬件配置,您可以在系统上运行 Llama 3。其1B型号是最轻的。您可以通过命令提示符在系统上安装并运行它。

Llama 3 需要多少内存?

Llama 3 最轻的型号是 Llama 3.2 1B。您的系统应具有 16 GB RAM 才能运行 Llama 3.2 1B 模型。除此之外,您的系统还应该有一个重型 GPU。 Llama 3 的更高型号需要更多的系统资源。

阅读下一篇:。

![安装驱动程序在安装Windows 11 [FIX]时显示硬件](https://sclub.homes/tech/blogs/wp-content/uploads/2025/03/Install-driver-to-show-hardware.png)